Procédure de gestion de la qualité des données 📊

QALITA Platform met au centre 🎯 de son fonctionnement la gestion de la qualité des données. Cette gestion est assurée et facilité par un ensemble de fonctionnalités qui permettent de :

- Mesurer la qualité 📏 des données et créer des rapports d'analyses.

- Détecter des anomalies 🔍 et savoir les traduire en actions.

- Prendre des actions correctives 🔧 et suivre leur exécution, mesurer leur impact.

Procédure de gestion de la donnée

Mesure de la qualité des données (1/2/3) 📈

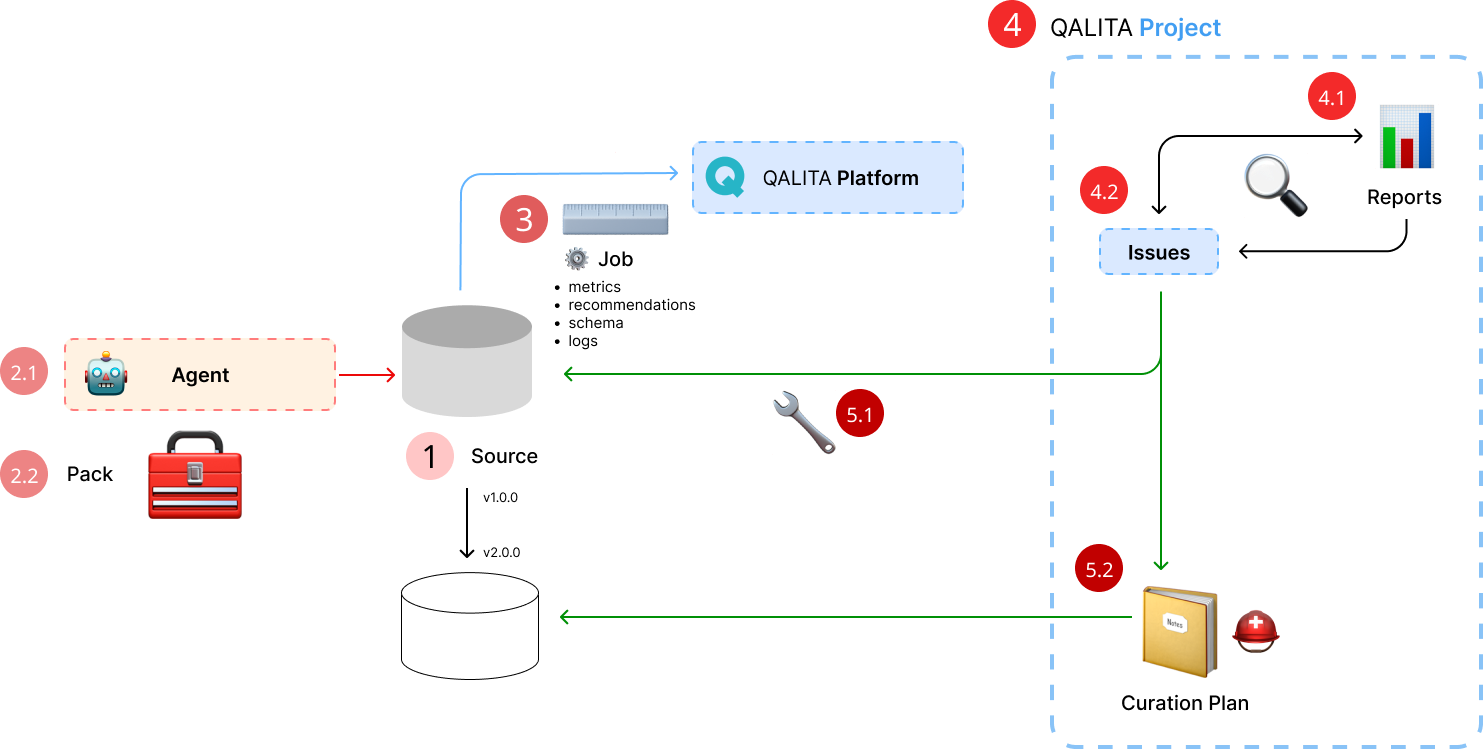

1 Source

La première étape consiste à référencer la source à mesurer dans la plateforme.

Cette étape est réalisée par un data ingénieur en utilisant la ligne de commande qalita-cli.

2.1 Agent

La deuxième étape consiste à enregistrer un agent capable de communiquer avec la source.

Cette étape est également réalisée par un data ingénieur en utilisant la ligne de commande qalita-cli.

2.2 Pack

Il faut ensuite créer un pack de mesure de la qualité des données.

Cette étape est également réalisée par un data ingénieur ou un data analyst en utilisant la ligne de commande qalita-cli.

Les packs sont catégorisés en fonction de la typologie d'analyse qu'ils produisent, par exemple : pack:quality:completeness pour mesurer la complétude des données.

QALITA Platform propose un ensemble de packs par défaut, mais il est possible d'en créer de nouveaux.

QALITA Platform supporte les packs de type :

completeness: Mesure la complétude des données.validity: Mesure la validité des données.accuracy: Mesure l'exactitude des données.timeliness: Mesure la ponctualité des données.consistency: Mesure la cohérence des données.uniqueness: Mesure l'unicité des données.reasonability: Mesure la raisonnabilité des données.

3 Analyse

La dernière étape consiste à lancer une analyse sur la source. Cette étape est réalisée par un data ingénieur en utilisant la ligne de commande qalita-cli. L'analyse est réalisée à partir d'un pack et d'un agent. Elle produit des métadonnées qui sont stockées dans la base de données de QALITA Platform.

- metrics : les métriques sont des indicateurs de qualité des données. Elles sont calculées par le packs à partir des données de la source.

- recommendations : les recommendations sont des suggestions d'amélioration relevé lors de l'analyse de la source par le pack.

- schema : le schema est la description de la structure des données. Cela permet d'associer les métriques et recommendations à des

périmètresde données. - logs : les logs sont les traces de l'analyse. Ils permettent de comprendre les calculs réalisés par le pack.

Détection des anomalies (4) 🔎

Les anomalies sont détectées par un data analyst ou un data manager en utilisant l'interface graphique de QALITA Platform. Les anomalies sont détectées à partir des métriques et des recommendations produites par les analyses. Elles sont ensuite associées à un ticket.

4 Projets

Pour permettre une meilleure organisation, il est possible de créer des projets qui regroupent des sources et des analyses.

Un projet regroupe :

- Une ou plusieurs sources de données référencés dans la plateforme.

- Les rapports d'analyses de la qualité des données.

- Les tickets associés aux sources de données du projet.

- Les plan de curation de la donnée.

Cela peut être particulièrement utile pour les projets de migration de données ou pour des projets de recherche impliquant plusieurs sources de données.

4.1 Rapports

Les rapports d'analyses sont des rapports qui permettent de visualiser les métadonnées des sources liés à un projet.

Ils sont générés par QALITA Platform, Ils peuvent êtres configurés pour afficher les métriques et les recommendations d'un ou plusieurs packs, sur une ou plusieurs source. Ils sont égalements partageables, ils permettent de faciliter le partage d'informations et la collaboration entre les différents acteurs d'un projet.

voir la page Rapport pour plus d'informations

4.2 Tickets

Les tickets sont des anomalies détectées par un data analyst ou un data manager. Ils sont associés à une source de données. Ils sont créés à partir des métriques et des recommendations des rapports d'analyses.

Les recommendations sont catégorisées en fonction de leur criticité :

- High : Les données sont inutilisables.

- Warning : Les données sont utilisables mais avec des risques.

- Info : Les données sont utilisables mais avec des risques limités.

Les tickets permettent de suivre les anomalies et les actions correctives associées. Il peuvent être gérés directement depuis la plateforme ou depuis un outil de gestion de projet comme Jira ou Trello grâce à l'intégration de QALITA Platform avec ces outils.

Actions correctives (5) 🛠️

il existe deux types d'anomalies possibles :

- L'anomalie est d'ordre humaine, (mauvaise saisie, mauvaise configuration, etc...) La donnée est mauvaise à la source, elle doit être corrigée.

- L'anomalie vient d'un problème technique, la donnée est mauvaise après transformation, elle doit être transformée, écartée, les programmes ETL doivent être corrigés.

5.1 Technique

Si l'anomalie est d'ordre technique QALITA Platform ne permet pas de la corriger directement. Il faut corriger le programme ETL qui est à l'origine de l'anomalie. Cela peut être réalisé par un data ingénieur. Néanmoins le suivi de la correction peut être réalisé par un data analyst ou un data manager en utilisant les tickets. Puis une nouvelle analyse peut être lancée pour vérifier que la correction a bien été prise en compte.

5.2 Humaine

Si l'anomalie est d'ordre humaine QALITA Platform permet de la corriger directement.

Pour cela il faut créer un plan de curation de la donnée. Un plan de curation est un ensemble d'actions correctives qui permettent de corriger une anomalie. Il est créé par un data analyst ou un data manager en utilisant l'interface graphique de QALITA Platform.

La source originale est recopié, puis les actions correctives sont appliquées sur la copie. Cela permet de conserver la source originale intacte. Une nouvelle version de la source est alors créée. Cette nouvelle version est ensuite analysée pour vérifier que les actions correctives ont bien été prises en compte.

Cette fonctionnalitée est en cours de développement. Elle est prévue d'ici la fin d'année 2024.